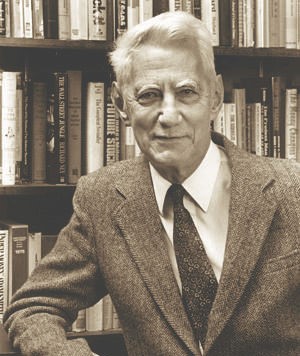

Claude Elwood Shannon,1916年4月30日—2001年2月24日

1936年获得密歇根大学学士学位。1940年在麻省理工学院获得硕士和博士学位,1941年进入贝尔实验室工作。

美国数学家、信息论的创始人。

时值1943年初,图灵正在访问他赴美之行的最后一站——贝尔实验室。他之所以来到这里,就是为了协助大西洋通信的语音加密工作(说白了就是给大西洋两岸传输的通话内容加密,这样敌人就无法监听)。不过,这次访问很快就因为另一个原因而变得收获颇丰。每天下午茶时间,图灵都会和实验室里的一位研究人员在食堂里长谈,这位研究人员名叫克劳德·香农(Claude Shannon)。两个人似乎都对计算机的问题非常热衷。图灵看问题主要从数学的视角出发,而香农的视角则完全不同。

逻辑思维

香农进入贝尔电话实验室实习,学习操作自动电话交换机。实习期间,他意识到了一件重要的事情。年轻的香农发现,有两个看似截然不同的事物其实具有共同的本质。

克劳德·香农回到麻省理工学院,发展他的理论新思想。那时候,他还没有和图灵见过面,图灵当时还是邱奇的学生,正在250英里(约合402公里)以外的普林斯顿大学攻读博士。两人共进午餐是六年以后的事情。

香农已经知道,数学上有一种逻辑代数系统,叫做布尔逻辑,它得名于英国数学家乔治·布尔(George Boole)。在布尔逻辑中,任何逻辑 表达式的计算结果都不是数值,而是“真”、“假”这两种真值。你只需要使用逻辑运算符“与”、“或”、“非”,就可以表达任何你想表达的逻辑语句。这个逻辑语句可以是一个英文句子,比如“在下雨且阴天或无 风的时候,我会带伞。”

布尔逻辑可以让我们描述和操纵逻辑表达式,这就和我们通过数学函数来操纵数字是一样的道理(正如上一章所讲的那样,所有的数学问题都可以归结为逻辑问题)。

香农取得的突破在于,他注意到,逻辑和开关电路具有共同的本质。他借鉴了布尔逻辑,并运用它来定义带有机电式继电器(电气开关)的电路。

香农的理论表明,整个电路都可以用布尔逻辑表述出来,只要巧妙地运用逻辑表达式,就可以简化和改善电路设计。

也就是在这个时候,人们开始着手制造世界上第一台电子计算机。由此可见,只要能够运用逻辑数学表达式设计出简洁而高效的电路,就能创造巨大的实用价值。由于所有的数学问题都可以归结为逻辑问题,而逻辑问题又可以通过电气开关表现出来,香农的理论表明,人们可以设计专门的电机,用来计算任何可计算的数学函数。

香农决定将他的思想写成研究报告发表出来,研究报告的题目是“继电器和开关电路的符号分析”(A Symbolic Analysis of Relay and Switching Circuits)。这项成果给计算机科学领域带来了重大突破。香农很快以此为基础,完成了他在麻省理工学院的硕士论文。这篇论文受到了广泛的赞誉,人们说它“或许是本世纪最重要、也最有名的硕士论文”。

24岁时,香农写了一篇博士论文,从代数学的角度描述遗传学和进化论。毕业后,他作为国家研究员(National Research Fellow),在声名远播的普林斯顿高等研究院(Institute for Advanced Study,简称IAS)工作了一年。在那里,他接触到了一些世界上最顶尖的人才,其中包括赫尔曼·外尔(Hermann Weyl)、阿尔伯特·爱因斯坦、库尔特·哥德尔和约翰·冯·诺依曼(John von Neumann)。1941年,香农进入贝尔电话实验室,继续扩充自己的理论思想。

两年后,在贝尔实验室的食堂,图灵在与香农交谈的过程中大为振奋——他的声音不由自主地越来越大,引起周围的人纷纷侧目。香农的话让他看到了希望曙光——图灵机或许真的可以变成现实!临走前,图灵买了一本电路入门书,把它带到回国的船上,在危险四伏的海上航程中如饥似渴地阅读起来。

其他贡献

香农理论的重要特征是熵(entropy)的概念,他证明熵与信息内容的不确定程度有等价关系。熵曾经是波尔兹曼在热力学第二定律引入的概念,我们可以把它理解为分子运动的混乱度。信息熵也有类似意义,例如在中文信息处理时,汉字的静态平均信息熵比较大,中文是9.65比特,英文是4.03比特。这表明中文的复杂程度高于英文,反映了中文词义丰富、行文简练,但处理难度也大。信息熵大,意味着不确定性也大。

众所周知,质量、能量和信息量是三个非常重要的量。

人们很早就知道用秤或者天平计量物质的质量,而热量和功的关系则是到了19世纪中叶,随着热功当量的明确和能量守恒定律的建立才逐渐清楚。能量一词就是它们的总称,而能量的计量则通过“卡、焦耳”等新单位的出现而得到解决。

然而,关于文字、数字、图画、声音的知识已有几千年历史了。但是它们的总称是什么,它们如何统一地计量,直到19世纪末还没有被正确地提出来,更谈不上如何去解决了。20世纪初期,随着电报、电话、照片、电视、无线电、雷达等的发展,如何计量信号中信息量的问题被隐约地提上日程。

1928年哈特利(R.V. H. Harley)考虑到从D个彼此不同的符号中取出N个符号并且组成一个“词”的问题。如果各个符号出现的概率相同,而且是完全随机选取的,就可以得到D^N个不同的词。从这些词里取了特定的一个就对应一个信息量I。哈特利建议用NlogD这个量表示信息量,即I=NlogD。这里的log表示以10为底的对数。后来,1949年控制论的创始人维纳也研究了度量信息的问题,还把它引向热力学第二定律。

但是就信息传输给出基本数学模型的核心人物还是香农。1948年香农长达数十页的论文“通信的数学理论”成了信息论正式诞生的里程碑。在他的通信数学模型中,清楚地提出信息的度量问题,他把哈特利的公式扩大到概率Pi不同的情况,得到了著名的计算信息熵H的公式:

H=-∑PilogPi

如果计算中的对数log是以2为底的,那么计算出来的信息熵就以比特(bit)为单位。在计算机和通信中广泛使用的字节(Byte)、KB、MB、GB等词都是从比特演化而来。“比特”的出现标志着人类知道了如何计量信息量。香农的信息论为明确什么是信息量概念作出决定性的贡献。

香农在进行信息的定量计算的时候,明确地把信息量定义为随机不定性程度的减少。这就表明了他对信息的理解:信息是用来减少随机不定性的东西。或香农逆定义:信息是确定性的增加。